自2019年以来,在线上发现的深度伪造视频数量每年增长900%。但更重要的是,这些视频的质量和制作的便捷性正在不断提高。

迄今为止最好的例子属于新奇或娱乐类别。要制作出如此优秀的结果需要真正的时间和专业知识。

肯德里克·拉马尔的音乐视频截图

现在,在另一端的光谱中,我们有像这个弗拉基米尔·泽连斯基的视频这样的视频,它显然是假的,大多数人觉得它相当可笑。

弗拉基米尔·泽连斯基的深度伪造,已经进入黄金时段的电视节目

稍微好一些的例子是乔·拜登宣布美国将加入乌克兰战争的视频,在视频中他说到...

“记住,你不是在把你的儿子和女儿送去打仗,而是在把他们送去自由。愿上帝保佑我们的军队,也愿上帝保佑乌克兰。”

这个视频远非完美,而且它有一个相当大胆的叙述,使它的可信度降低了。

但在我们对这种假视频的威胁进行驳斥之前,这里有四点值得注意。

- 专业知识将会传播

就像任何新技术一样,这个社区中的知识和专业知识只会增加。更多的专家意味着更多和更好的内容。

- 门槛将会降低

随着技术变得更容易使用,门槛只会越来越低。像这样目前需要一周左右的时间制作的东西最终将需要几个小时甚至几分钟。

- 脆弱的人群已经面临风险

今天,甚至是制作不好的假内容,不是每个人都有能力识别,老年人就是其中之一。

- 深度伪造策略将成熟

这些假内容背后的策略将会成熟。我认为我们将会看到更少像乔·拜登深度伪造那样引人注目的视频,而是看到更多隐蔽、低调的假内容。

我们已经经历过这样的事情

当社交媒体在2010年成为主流时,任何资源有限的团体都可以影响大规模的公众舆论,当时我们还不知道。人工智能生成的内容将把这一切带到一个全新的地方。

假新闻和新闻一样古老

假新闻并不新鲜,但由于人工智能的出现,生成和分享假新闻变得比以往任何时候都更容易。只要正确的训练数据和指令就位,人工智能驱动的内容,如图片、视频甚至研究论文,可以在很少的人类输入下被创建和分发。这意味着更多的内容和增加的可信度。

例如,看看这篇2019年的假帖子,它被观看了约2400万次。

2019年被观看了约2400万次的假帖子(带有真实的摄影)

现在想象一下,同一篇假新闻的多个版本同时发布,每个版本都有不同的标题、不同的图像和不同的视频,从不同的来源发布。这将创造出广泛的覆盖范围的假象,使其看起来比过去的假新闻更加可信。

使用Mijourney(图像)和ChatGPT(文本)生成的假帖子的示例

使用Mijourney(图像)和ChatGPT(文本)生成的假帖子的示例

好的假内容变得流行的副作用是,所有内容都会失去可信度,任何东西都可以被标记为假的,这才是真正的威胁。

好的假内容变得流行的副作用是,所有内容都会失去可信度,任何东西都可以被标记为假的,这才是真正的威胁。

好了,关于媒体的话说得够多了,现在让我们看看这项技术如何被用来针对像你和我这样的普通人。

还有其他用途吗?

不仅是公众人物可以被伪造,这位记者创建了自己的声音模型,并在此视频中使用它访问他的在线银行。

深度伪造音频诈骗已经在今天发生。2020年,香港一名银行经理被欺骗发起价值3500万美元的电汇。深度伪造音频被用来模仿银行的一名董事在电话中发言,这与那位董事的假电子邮件结合在一起,支持了所说的内容。

好的,让我们快速地看看其他一些用例。

操纵金融市场

2022年2月3日,Meta的市值损失了2320亿美元。为什么?一份平淡无奇的财报令投资者陷入困境,这种类型的公告很容易被伪造,以影响未来股价。

因平淡无奇的财报而在2022年2月3日Meta的市值损失了2320亿美元

证据篡改

当虚假内容进入法庭时会发生什么?在英国已经发生过这种情况,一位外籍律师的客户被控威胁妻子,家庭法庭审判期间提交了一段假音频作为证据。“她制造了一段音频文件,看起来就像这个孩子的父亲说了一些他从未说过的话。这是非常有趣的一部分,因为她不是专家,但通过一个在线公司的帮助,她成功地编辑了一段音频文件。有趣的是,她用来进行编辑的数据是她手机上记录他说话的数百个小时的录像……”

替罪羊

回到2009年,克里斯蒂安·贝尔的一段片场情绪崩溃的音频剪辑走红网络。如果今天这种情况发生,并且有人声称这是深度伪造,那么这完全是可信的。深度伪造的指责可能成为一个常见的替罪羊。

协调暴力

不清楚唐纳德·特朗普说的话是否导致了2021年1月暴徒冲击美国国会大厦,但有一件事是清楚的,即在高度紧张的时刻能够模仿有影响力的人物可能对人类行为产生真正的影响,特别是当大群人在同一时间、同一地点时。

2021年1月国会暴动的场景

深度伪造色情内容

深度伪造色情内容已经是一个巨大的问题,它负责网络上大多数深度伪造视频,对任何有线上存在的女性都将成为一个日益严重的问题。

边缘群体

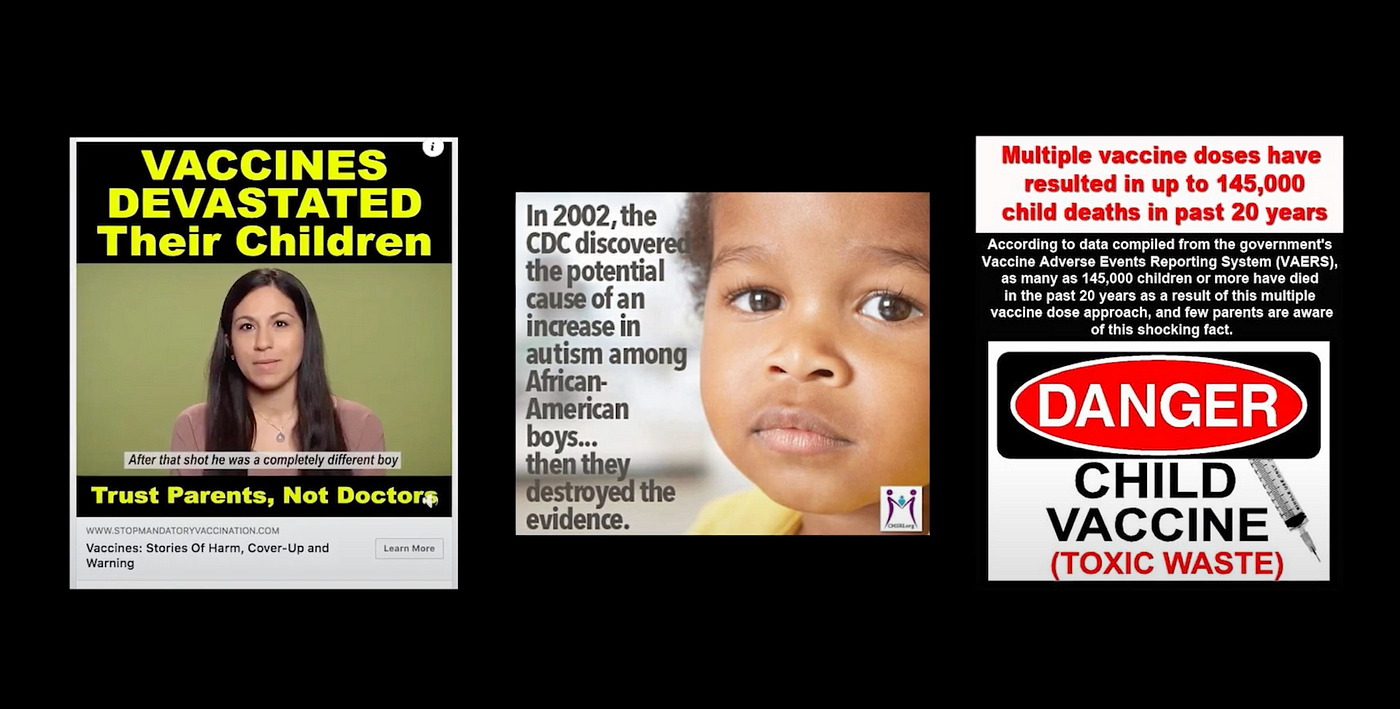

反疫苗群体等边缘群体不陌生于使用误导性帖子推动议程。当专家或悲痛的家长可以被伪造时,这些帖子将变得更加有力。

关于反疫苗运动的一些误导性帖子的录音示例

那么,我们能做些什么?

好的,那么我们能做些什么呢?肯定有一种方法可以检测和抑制虚假内容。事实上,我们已经有了这种类型挑战的一个好案例,我们只需要看看恶意软件领域。

介绍恶意软件

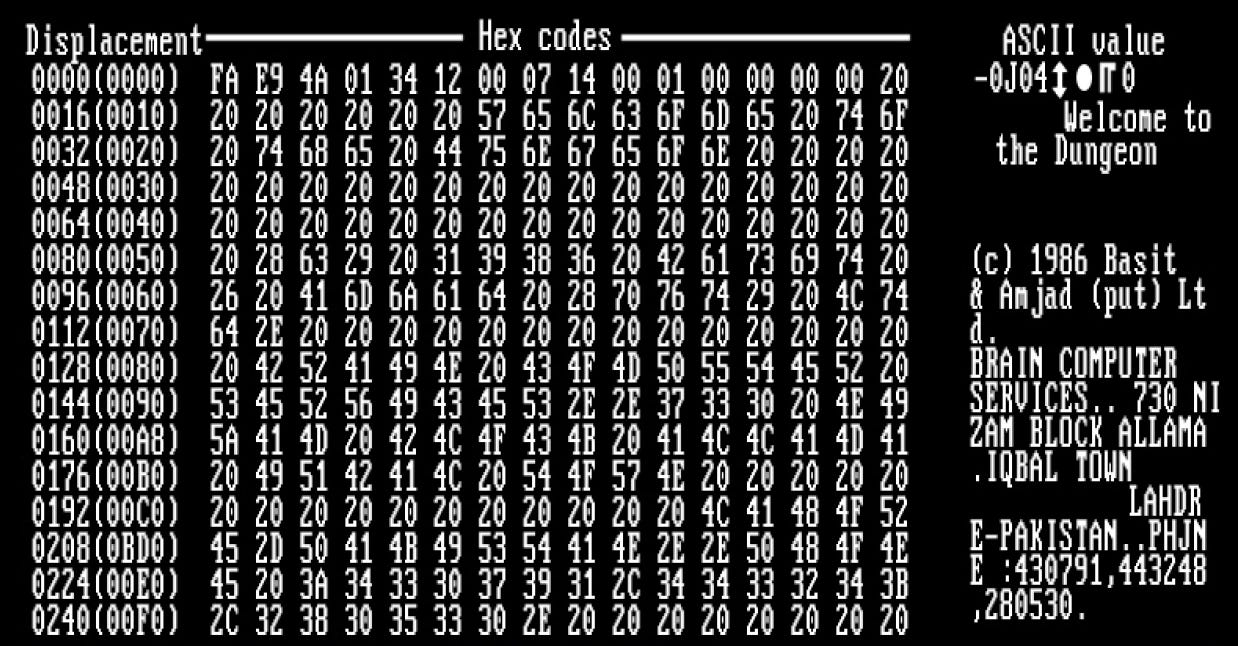

Brain是1986年首个在野外出现的计算机病毒,然后是像McAfee这样的防病毒软件。

一台计算机被现在著名的“Brain”病毒感染的启动屏幕截图

这导致病毒制造者和安全研究人员之间展开了一场军备竞赛,双方试图互相智胜。这个来回的竞争在过去几十年里一直在演变,随着恶意软件的演变,反恶意软件软件也在不断演变。

问题在于病毒制造者总是占据优势,他们总是先发制人。所有安全研究人员能做的就是等待新病毒被发现,然后在他们的系统中考虑这种新病毒。

这可能是深度伪造之战的开始方式,首先深度伪造变得足够好,可以欺骗我们的眼睛和耳朵,然后深度伪造制造者和深度伪造检测器之间就开始了一场来回的竞争。

深度伪造展示了伯特·雷诺兹出演詹姆斯·邦德(右)的场景,原始演员肖恩·康纳利(左)也出现在镜头中。

使用算法检测深度伪造

Facebook于2019年举办了深度伪造检测挑战赛,并向前五名获奖者颁发了总计100万美元的奖金。参赛者建立了一个检测器模型,将其训练在一个包含100,000个深度伪造视频的数据集上。超过35,000个模型被提交,获胜模型在训练视频集上的准确率达到了82%。然后在一个它没有接触过的数据集上实现了65%的准确率。

这两个数字之间的差异突显了训练数据的问题,我们只能用我们知道是假的视频来训练我们的检测模型。换句话说,我们不知道我们不知道的东西。

如果基于算法的检测不是全部答案,那么我们该怎么办呢?能够通过独立来源验证媒体文件、记录和确认文件来源,甚至可以应用数字水印,所有这些都可能证明是有效的,所有这些都可以融入我们的媒体平台。此外,我们可能会看到对可靠和独立新闻的需求增加,新闻机构将更多地投资于验证内容和揭穿虚假信息。

我们正在经历数字革命,曾经是科幻小说的许多事情现在都变成了现实,无论你觉得这是令人兴奋还是令人不安,有一件事是肯定的,变化的速度只会越来越快。

我现在要留给你的是一个深度伪造的理查德·尼克松读出的演讲,这篇演讲从未被朗读。

如果你喜欢这篇文章,请查看下面的视频版本,其中包含无法很好地转化为书面格式的大量信息。

观看这篇文章的完整视频版本,其中包含大量视觉示例。

译自:https://medium.com/@bitculturetv/how-deepfakes-and-ai-are-changing-the-real-world-48e0667d05f7

评论(0)